IMAGEM: Divulgação/Google

O limite da computação foi alcançado, agora, é a vez da computação quântica

A era da computação clássica está no limite. A próxima revolução já começou: a computação quântica.

TECNOLOGIA

Por Bruno Jardim

9/18/20255 min read

Antes de falarmos sobre computação quântica, essa tecnologia emergente que promete transformar indústrias inteiras, da saúde à segurança de dados, é importante entender de onde ela vem. Para compreender como chegamos ao ponto de usar partículas subatômicas como unidades de informação, precisamos voltar no tempo, para o início do século XX, quando os primeiros sinais de que o mundo era mais estranho do que imaginávamos começaram a aparecer.

Naquela época, os físicos acreditavam que já haviam desvendado quase todos os mistérios do universo. Mas algo curioso começou a acontecer: fenômenos observados em laboratório não faziam sentido dentro das regras da física clássica. Um deles foi o chamado efeito fotoelétrico. Imagine uma chapa de metal sendo iluminada por uma lanterna, em vez de apenas esquentar, ela começava a liberar elétrons, pequenas partículas carregadas de energia. Isso parecia mágica aos olhos da física tradicional.

Em 1905, Albert Einstein explicou que a luz vinha em pequenos pacotes de energia, os quanta. Era como se a luz fosse feita de balas energéticas capazes de derrubar elétrons. Essa ideia não apenas lhe rendeu um Prêmio Nobel, como também deu início à chamada revolução quântica.

Nos anos seguintes, o quebra-cabeça só aumentou. Max Planck, Niels Bohr, Erwin Schrödinger e Werner Heisenberg lançaram os fundamentos da mecânica quântica. Bohr sugeriu que os elétrons giravam em órbitas específicas, como planetas seguindo trilhas invisíveis. Schrödinger propôs que as partículas eram também ondas. E Heisenberg mostrou que não podíamos saber tudo sobre uma partícula ao mesmo tempo, como tentar capturar a posição exata de uma bexiga de sabão flutuando no ar.

Essas ideias, embora parecessem absurdas, foram confirmadas por experimentos e mudaram para sempre a nossa forma de ver o universo. Agora, mais de um século depois, estamos começando a usar esses mesmos princípios para criar computadores capazes de resolver problemas que os supercomputadores atuais levariam séculos.

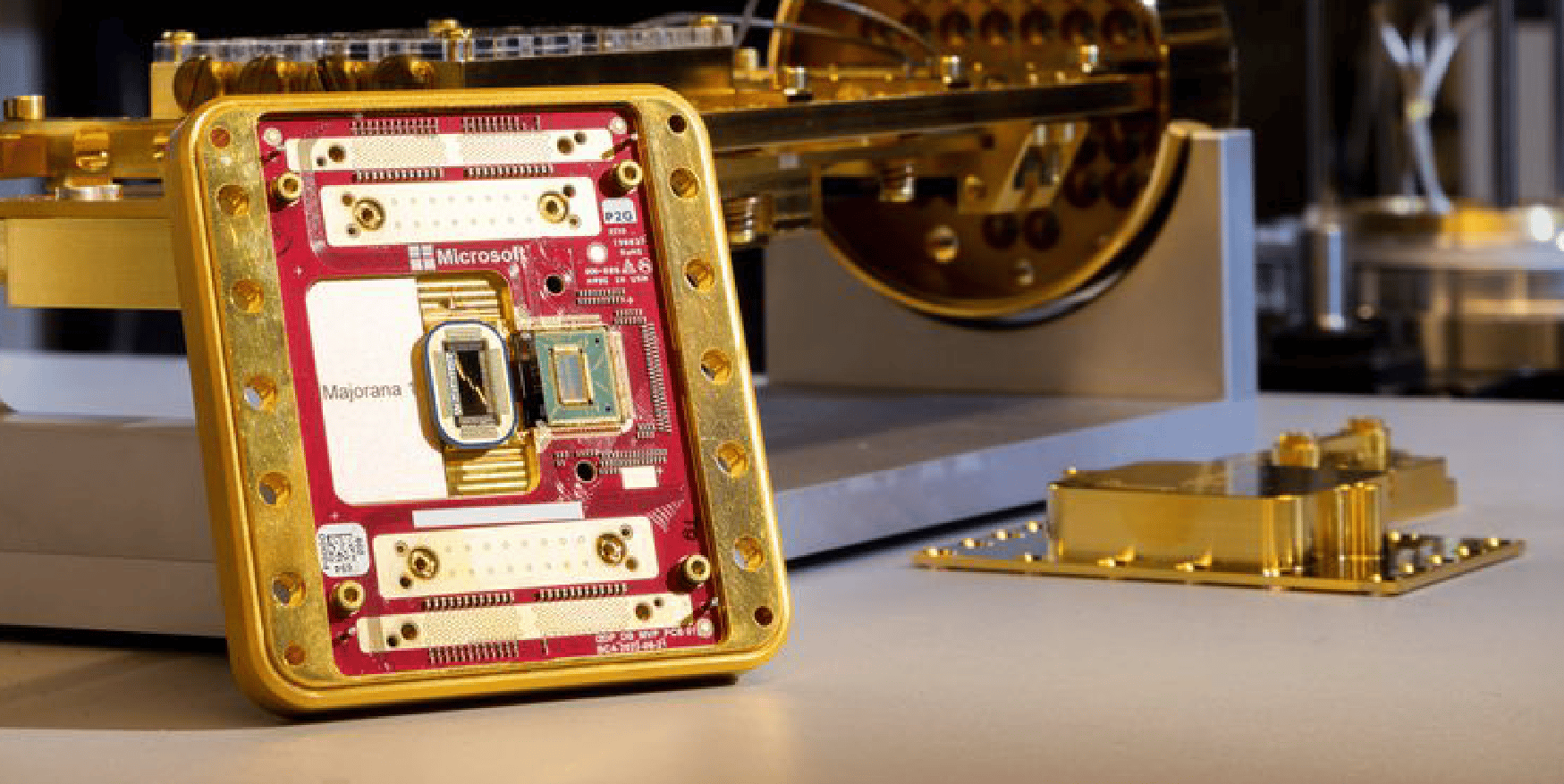

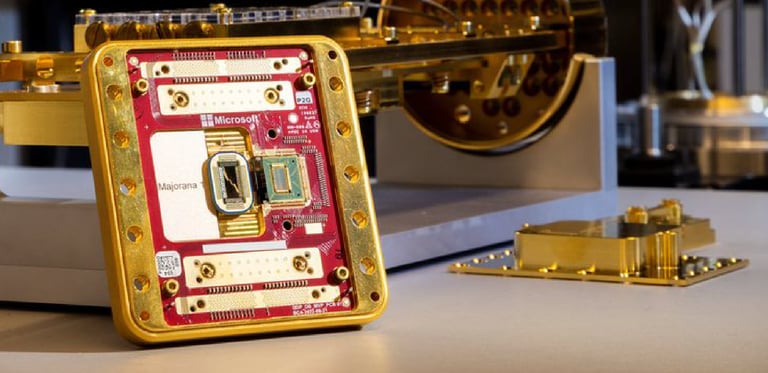

Primeiro processador quântico da Microsoft, Majorana 1 é a aposta da companhia para a nova era da computação (Imagem: Divulgação/Microsoft)

Os limites da computação clássica

Durante décadas, os computadores clássicos passaram por uma impressionante trajetória de miniaturização e ganho de desempenho. Os primeiros modelos, nos anos 1940, ocupavam salas inteiras, usavam válvulas a vácuo e realizavam cálculos simples em horas. Com o tempo, vieram os transistores, os circuitos integrados e, mais tarde, os microprocessadores, permitindo o surgimento de computadores pessoais, laptops e smartphones.

Um dos princípios que guiou essa evolução foi a chamada Lei de Moore, formulada por Gordon Moore, cofundador da Intel, na década de 1960. Ela previa que o número de transistores em um chip dobraria a cada 18 a 24 meses, o que, na prática, significava computadores cada vez mais poderosos e baratos.

Essa previsão se manteve por mais de cinco décadas, mas, nos últimos anos, começamos a nos aproximar de um limite físico intransponível. Os transistores atuais já têm dimensões de poucos nanômetros. Nesse nível, os efeitos da mecânica quântica tornam-se inevitáveis. O tunelamento quântico, por exemplo, faz com que elétrons atravessem barreiras, gerando vazamentos de corrente elétrica e instabilidades.

Além dos limites físicos, há também limites computacionais. Problemas como fatoração de grandes números primos (base da criptografia), simulação precisa de moléculas e otimização de cadeias logísticas permanecem inalcançáveis para máquinas clássicas. O tempo necessário cresce exponencialmente, tornando inviável mesmo para supercomputadores.

Essas limitações nos levam a buscar uma nova arquitetura: a computação quântica, que surge não como substituta, mas como complemento à lógica binária.

A Computação Quântica

Diferente dos bits (0 ou 1), a computação quântica usa qubits, capazes de estar em 0 e 1 ao mesmo tempo (superposição) e de influenciar uns aos outros à distância (entrelaçamento). Essas propriedades permitem explorar múltiplos caminhos simultaneamente, gerando saltos exponenciais de desempenho.

Desde 2019, quando o Google anunciou que seu processador Sycamore completou em 200 segundos um cálculo que levaria milhares de anos em um supercomputador clássico, a corrida global ganhou fôlego. Em 2023, a empresa apresentou o processador Willow, com 105 qubits, capaz de realizar, em minutos, operações que levariam mais que a idade do universo em sistemas clássicos.

Esse entusiasmo também se reflete em investimentos públicos e privados:

Em setembro de 2025, o estado do Novo México anunciou US$ 315 milhões em infraestrutura quântica.

No Reino Unido, empresas como Oxford Quantum Circuits já oferecem computação quântica com correção de erros em data centers comerciais.

A Quantinuum fechou um acordo de US$ 1 bilhão com o governo do Catar para aplicações em genômica, segurança e modelagem molecular.

Impactos por setor

Materiais e energia: descoberta de baterias de alta densidade e supercondutores.

Saúde e biomedicina: aceleração no desenvolvimento de medicamentos.

Genética: terapias personalizadas a partir da análise de grandes volumes de dados.

Segurança de dados: construção de canais de comunicação teoricamente invioláveis.

Segundo a McKinsey & Company, o mercado global de computação quântica deve movimentar US$ 97 bilhões até 2035, impactando inteligência artificial, química, logística, finanças e defesa.

Estamos testemunhando o início de uma nova era. A computação quântica não é apenas uma tecnologia emergente, mas um novo paradigma que exige aprendizado, investimento e visão estratégica.